釋放車載 AI 的力量

AI Director 通過簡化車載 AI 的開發、部署與管理,幫助 OEM 更快、更低成本地將智能化、可適應的車輛推向市場。

加速模型部署

統一分散的工作流程,實現跨團隊、跨工具和跨計算平台的快速、自動化 AI 模型部署

- 精簡端到端 AI 生命週期:數據 → 模型 → 部署 → 反饋

- 縮短 AI 功能的上市時間

- 在多個車型和領域擴展模型部署

- 降低整合和驗證的工程開銷

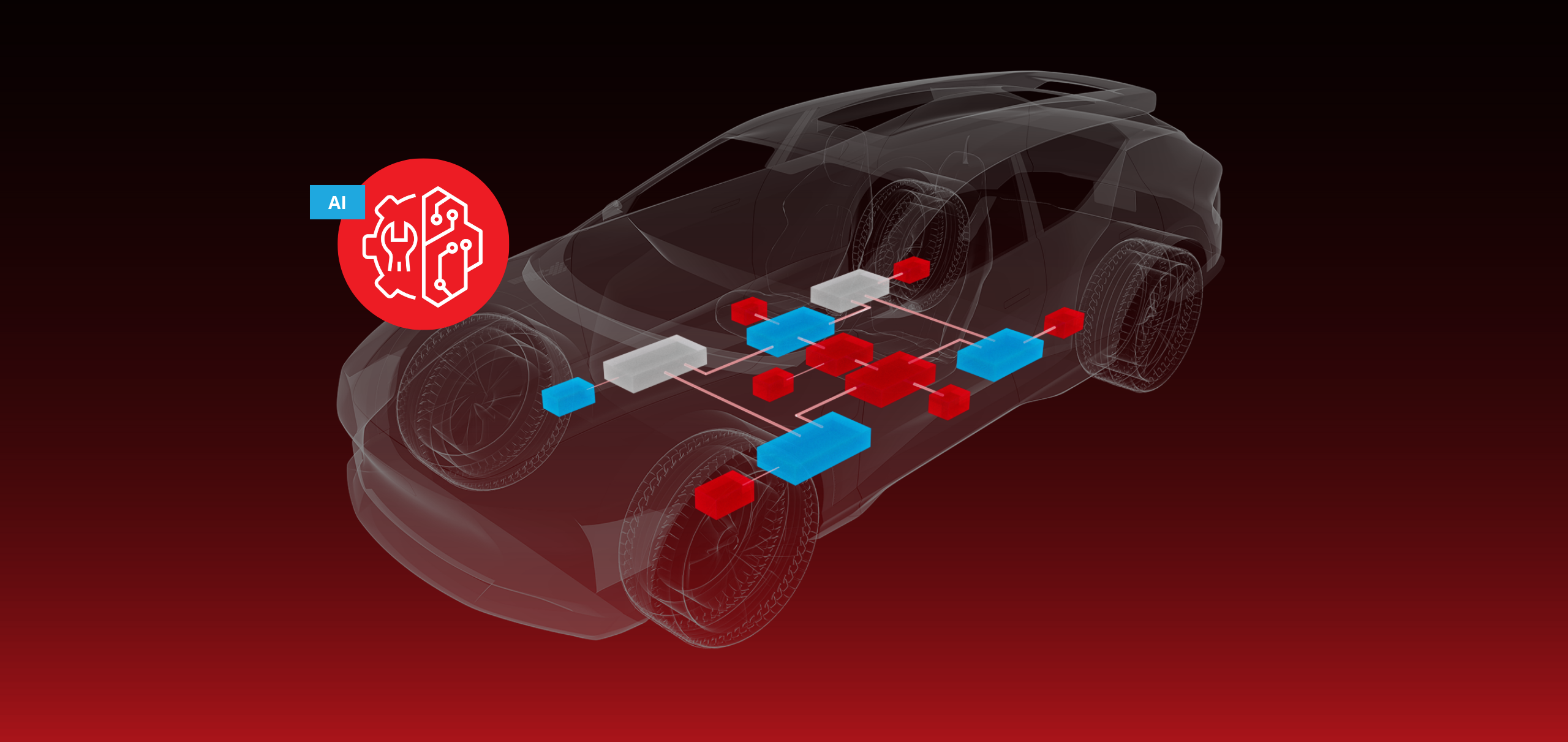

硬體效率最大化

為不同類型的車載計算優化模型,確保在各類 ECU 上高效、高性能運行,而無需過度配置。

- 確保模型針對目標 ECU 優化

- 支持多樣化的晶片廠商而無需重寫模型

- 利用晶片特定加速(CPU、GPU、NPU)

- 最小化計算、功耗和散熱負擔

擴展 AI 工作流

標準化整合與數據訪問,實現 AI 模型在 OEM、供應商和車輛平台間的一致性部署

- 為所有模型供應商提供統一的運行時和部署接口

- 為所有模型供應商提供統一的運行時和部署接口

- 無縫連接模型與正確的車輛信號

- 降低每個模型的整合成本與複雜性

- 簡化 OEM、一級供應商、雲端與 IP 供應商之間的協作

解決方案簡介

大規模交付車載邊緣 AI

功能特性

AI Director 是一款端到端工具鏈,用於在車載邊緣部署、管理和擴展 AI 工作負載。它專為汽車環境的獨特限制與機遇而打造,將 AI 生命週期,從模型訓練到實時推理,統一起來,並通過精簡的整合、優化和監控工具實現全流程支持。

模型部署

- 統一的工具鏈與運行時,用於模型優化與部署

- 與車輛 ECU 和雲平台的整合

- 與全車範圍數據源的整合

- 內置支持汽車 MLOps 與數據反饋循環

硬體優化

- 面向硬體的模型優化與調優層

- 運行時適配 ECU 的能力與限制

- 晶片廠商工具鏈的連接器

- 具備資源感知的模型執行選項

統一工作流

- 標準化的 API、數據模型和運行時行為

- 與模型特定數據源的無縫整合

- 基于插件的架构,支持多样化AI工作负载

- 安全的數據訪問與治理控制